Perché bloccare GPTBot e altri web crawlers AI è una mossa sbagliata

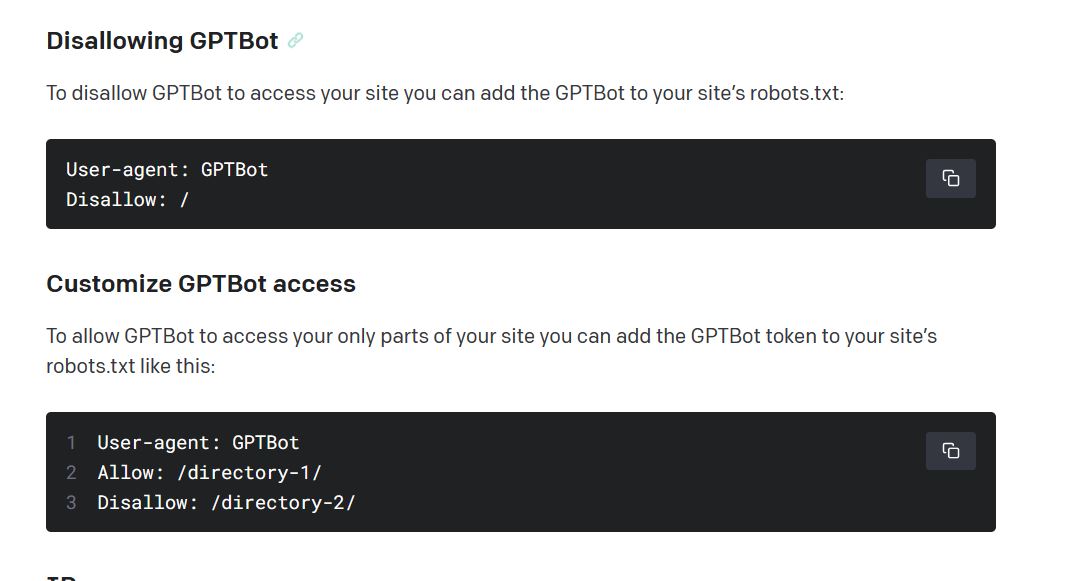

OpenAI ha annunciato il supporto del robots.txt per GPTBot, il che significa che puoi bloccare OpenAI dalla raccolta dei contenuti del tuo sito web.

Come sanno gli specialisti dell’ottimizzazione dei motori di ricerca, questa pratica è già disponibile da anni per i motori di ricerca, alcuni strumenti SEO e altri popolari web scrapers – tuttavia non molti siti web ne fanno buon uso.

Oggi gli specialisti SEO consigliano di bloccare GPTBot e altri web crawlers AI (o meglio, web scrapers poiché non si tratta propriamente di motori di ricerca).

Tuttavia, bloccare GPTBot per un intero dominio web è una mossa sbagliata.

Ciò che conta per un marchio non è il traffico del sito web ma la persuasione delle informazioni.

Bloccare tout-court i bot AI impedirà la visibilità narrativa del marchio di proprietà sulle fonti di conoscenza di domani (i chatbot conversazionali sono i motori di ricerca di domani). Se necessario, meglio limitare il loro accesso a specifiche aree del sito.

Si spera che l’imminente passaggio dalle pagine gialle intelligenti (Google) ai consulenti intelligenti (chatbot conversazionali potenziati dall’intelligenza artificiale) renderà la corsa alla classifica SERP (Search Engine Result Page) un ricordo del passato.

Il settore del marketing digitale dovrebbe sbarazzarsi delle tattiche SEO grigie volte a ingannare gli algoritmi e passare alla condivisione di informazioni significative.

Gli strumenti di IA generativa nella ricerca visti finora (Bing, You, Google SGE) sembrano essere in grado di sostituire le funzioni di ricerca “tradizionali”.

I risultati di ricerca sono permeati dall’intelligenza artificiale, sebbene non ancora di tipo conversazionale

Tuttavia, cosa si può definire “tradizionale” al giorno d’oggi? Le SERP sono già piene di funzioni in cui l’intelligenza artificiale svolge un ruolo importante. Oltre agli annunci di ricerca (intelligenti), pensa ai rich snippet, ai confronti, alle risposte, alle informazioni personalizzate/locali e così via.

Molte altre funzioni preziose e attraenti spingono già verso il basso i risultati della ricerca organica.

L’intelligenza artificiale riassume i risultati più rilevanti provenienti da varie fonti in un unico snippet, anziché elencare separatamente i risultati di ciascuna fonte.

Un modo per ottenere una rapida adozione delle funzioni di ricerca conversazionale basate sull’intelligenza artificiale è quello di proporre dinamicamente domande lunghe in base alle richieste dell’utente, tenendo conto della cronologia delle ricerche attuali: la tempistica è un aspetto cruciale, poiché l’intenzione di ricerca dell’utente cambia in base alla fase dell’imbuto determinata dalle query di ricerca.

Gli algoritmi dei motori di ricerca hanno trasformato il web in una landa desolata di mediocrità

Gli attuali criteri di posizionamento dei motori di ricerca hanno trasformato il web in una landa desolata di mediocrità generata dalla SEO.

Tuttavia, i contenuti più visibili e di valore tendono a essere non promozionali, di provenienza popolare, ricchi e aggiornati, mossi dall’altruismo piuttosto che da obiettivi puramente promozionali – pensa a Wikipedia.

La maggior parte della cosiddetta rispettabile industria dei media è finita in cattive tecniche di clickbait, eleganti notizie false, circondate da tonnellate di pubblicità fastidiose e spesso offerte dietro paywall.

Nessuna organizzazione è onesta, comprese le fabbriche di notizie, che promuovono programmi specifici in base ai loro investitori, inserzionisti, posizioni, ecc.

Le singole voci perseguono i loro interessi. Solo le informazioni raccolte in crowdsourcing possono essere considerate valide poiché portano molte voci nel processo di narrazione.

Pertanto le risposte basate su più fonti tendono ad essere più valide delle risposte basate su singole fonti.

La qualità > quantità prevale sempre nel mondo degli affari, almeno nel medio/lungo termine. Le vittorie a breve termine non assicurano la sostenibilità del business.

La recente evoluzione del capitalismo ha visto delegare gli sforzi di marketing ai clienti, premiando evangelisti/early adopters. Si può pensare a una forma di missionari religiosi devoti ai brand commerciali – si pensi ai fanatici di Apple, Tesla, il primo OnePlus e quant’altro – beneficiando delle funzionalità sociali offerte dalle piattaforme di comunicazione digitale.

In effetti, le recensioni potenziate dalle piattaforme digitali sono potenti motori di profitto: il passaparola è ancora il canale di marketing più efficace.

Tuttavia, sappiamo tutti come le recensioni false (come le notizie false) influenzino la loro validità.

E oltre a ciò, “la saggezza della folla” non è poi così saggia, considerando, ad esempio, i risultati elettorali che sono massicciamente alimentati dalla propaganda di merda in tutto il mondo.

Quindi gli strumenti di intelligenza artificiale potrebbero essere un modo migliore per selezionare e interpretare contenuti validi, andando oltre i contenuti di parte, le prove sociali di massa o i contenuti guidati dalla SEO.

Gli strumenti di intelligenza artificiale possono aiutare a sbarazzarsi di tutte quelle pagine costruite con l’unico scopo di primeggiare nelle SERP.

Ogni piattaforma digitale punta a trattenere gli utenti nel loro interno

Prima che qualsiasi vendita, interazione o anche solo persuasione, le piattaforme digitali sono affamate del tuo bene più prezioso di sempre: il tuo tempo.

Tempo significa consumo, e il consumo crea spazi pubblicitari, ovvero opportunità di guadagno.

Non conta il numero assoluto di profili (o meglio, di utenti, considerando che un utente può disporre di più profili), ma il tempo che gli utenti spendono sulla piattaforma, prim’ancora che il modo in cui lo spendono.

A tutti i presunti professionisti SEO spaventati dalla crescente quantità di web scrapers degli strumenti di AI, vale la pena ricordare che un obiettivo fondamentale di qualsiasi piattaforma digitale (social network e motori di ricerca) è quello di mantenere gli utenti all’interno della piattaforma.

Lasciare che un utente si allontani da una piattaforma è un costo che gli annunci pubblicitari devono compensare.

Per i siti web, ottenere traffico gratuitamente sarà più difficile quando le soluzioni offerte dalle piattaforme di ricerca (compresi i social network) saranno più ricche e fluide.

Saltare le piattaforme di ricerca significa perdere i mercati in cui gli utenti trascorrono la maggior parte del loro tempo.

Molte aziende non avranno bisogno di un sito web ricco (che rappresenta un costo considerevole per essere perfetto in termini di contenuti, design, SEO, UX, hosting, sicurezza, integrazioni, traduzioni, ecc.), ma potranno alimentare una piattaforma globale con i loro feed tramite API, concentrandosi sugli elementi fondamentali della loro attività: prodotti/servizi (inclusi i prezzi) e CX. I loro asset principali, i pubblici, saranno basati su dati primari, poiché anche i pixel apparterranno al passato.

La nuova SEO potrebbe essere definita AIO

Come ho scritto qualche tempo fa su LinkedIn, l’AIO (Artificial Intelligence Optimisation) potrebbe essere la definizione della nuova SEO in uno scenario in cui gli strumenti di intelligenza artificiale saranno pienamente integrati nelle piattaforme di ricerca. Se vuoi evitare la competizione, blocca pure i web scrapers dell’AI e la tua narrativa del tuo brand non sarà più menzionata. Ma altri potranno comunque parlare del tuo brand, impedendoti di partecipare al dibattito su di esso quando spunterà fuori nelle chatbot conversazionali alimentate dall’AI che popoleranno i risultati di ricerca.